So sánh 8 thuật toán học máy

0

0

6878

6878

So sánh 8 thuật toán học máy

Trong bài viết này, chúng ta sẽ xem xét một số trường hợp ứng dụng của các thuật toán phổ biến và những ưu và nhược điểm của chúng.

Có quá nhiều thuật toán học máy, phân loại, hồi quy, tập hợp, đề xuất, nhận dạng hình ảnh, v.v. Thật không dễ để tìm một thuật toán phù hợp, vì vậy trong thực tế, chúng tôi thường sử dụng phương pháp học tập mở rộng để thử nghiệm.

Thường thì chúng ta sẽ bắt đầu với những thuật toán mà chúng ta đồng ý với nhau, như SVM, GBDT, Adaboost, nhưng giờ đây học tập sâu đang được ưa chuộng, và mạng lưới thần kinh cũng là một lựa chọn tốt.

Nếu bạn quan tâm đến độ chính xác, cách tốt nhất là kiểm tra từng thuật toán một, so sánh, sau đó điều chỉnh tham số để đảm bảo mỗi thuật toán đạt được giải pháp tối ưu, và cuối cùng chọn một trong những tốt nhất.

Nhưng nếu bạn chỉ đang tìm kiếm một thuật toán đủ tốt để giải quyết vấn đề của bạn, hoặc có một số mẹo để tham khảo, hãy phân tích ưu và nhược điểm của từng thuật toán, dựa trên ưu và nhược điểm của thuật toán, sẽ dễ dàng hơn cho chúng ta để lựa chọn nó.

- ## Bias và chênh lệch

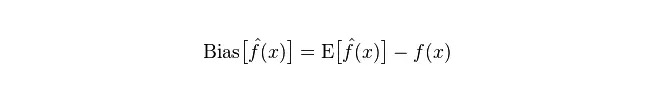

Trong thống kê, một mô hình tốt hay xấu được đo dựa trên sự sai lệch và chênh lệch, vì vậy chúng ta hãy phổ biến sự sai lệch và chênh lệch:

Phân biệt: mô tả khoảng cách giữa giá trị dự đoán (giá trị ước tính) của giá trị dự đoán (giá trị ước tính) và giá trị thực tế (giá trị thực tế). Phân biệt càng lớn, dữ liệu thực tế càng xa.

Phân tích: mô tả phạm vi thay đổi của giá trị dự báo P, mức độ phân tán, là sự chênh lệch của giá trị dự báo, tức là khoảng cách từ giá trị mong đợi của nó là E. Sự chênh lệch càng lớn, phân bố dữ liệu càng phân tán.

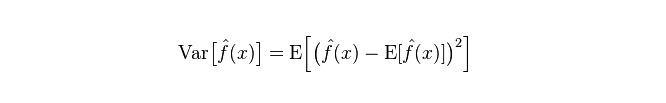

Lỗi thực tế của mô hình là tổng của cả hai, như sau:

Nếu là tập huấn nhỏ, phân loại có độ lệch cao/có độ chênh lệch thấp (ví dụ, Bayes NB đơn giản) sẽ có lợi thế lớn hơn phân loại có độ lệch thấp/có độ chênh lệch cao (ví dụ, KNN), vì sau này sẽ quá phù hợp.

Tuy nhiên, khi tập huấn của bạn phát triển, mô hình dự đoán dữ liệu ban đầu tốt hơn, độ lệch sẽ giảm, và các phân loại độ lệch thấp / độ lệch cao sẽ dần thể hiện lợi thế của nó (vì chúng có độ lệch cận thấp hơn), và các phân loại độ lệch cao sẽ không đủ để cung cấp mô hình chính xác.

Tất nhiên, bạn cũng có thể coi đây là một sự khác biệt giữa mô hình tạo ra (NB) và mô hình phân định (KNN).

- ## Tại sao người ta lại cho rằng Bayes ngây thơ là người có độ lệch cao và độ lệch thấp?

Những người này là những người có quyền tự do và tự do.

Đầu tiên, giả sử bạn biết mối quan hệ giữa tập huấn và tập kiểm tra. Nói một cách đơn giản, chúng ta sẽ học một mô hình trong tập huấn và sau đó sử dụng tập kiểm tra.

Nhưng rất nhiều lần, chúng ta chỉ có thể giả định rằng tập kiểm tra và tập huấn luyện phù hợp với cùng một phân bố dữ liệu, nhưng không có dữ liệu kiểm tra thực sự. Tại sao chúng ta chỉ nhìn vào tỷ lệ lỗi đào tạo để đo lường tỷ lệ lỗi kiểm tra?

Vì có rất ít mẫu đào tạo (hoặc ít nhất là không đủ), mô hình thu được thông qua tập huấn không bao giờ là chính xác. Ngay cả khi tập huấn chính xác 100%, nó cũng không có nghĩa là nó vẽ một phân bố dữ liệu thực sự. Mục đích của chúng tôi là vẽ một phân bố dữ liệu thực sự, chứ không phải chỉ vẽ một số điểm dữ liệu hạn chế của tập huấn.

Và, trong thực tế, các mẫu đào tạo thường có một số sai sót về tiếng ồn, vì vậy nếu quá cố gắng để đạt được sự hoàn hảo trong tập huấn luyện và sử dụng một mô hình rất phức tạp, nó sẽ khiến mô hình coi tất cả các sai sót trong tập huấn luyện là đặc điểm phân bố dữ liệu thực sự, và kết quả là ước tính phân bố dữ liệu sai.

Trong trường hợp này, khi đến tập thử nghiệm thực sự, nó sẽ bị nhầm lẫn một cách rất rõ ràng (hình ảnh này được gọi là phù hợp). Tuy nhiên, bạn không thể sử dụng mô hình quá đơn giản, nếu không, khi phân bố dữ liệu phức tạp hơn, mô hình sẽ không đủ để mô tả phân bố dữ liệu (thậm chí trong tập huấn luyện, tỷ lệ lỗi rất cao, hiện tượng này không phù hợp).

Quá phù hợp cho thấy mô hình được sử dụng phức tạp hơn so với phân phối dữ liệu thực, trong khi thiếu phù hợp cho thấy mô hình được sử dụng đơn giản hơn so với phân phối dữ liệu thực.

Trong khuôn khổ học thống kê, khi người ta vẽ mô hình phức tạp, có quan điểm rằng Error = Bias + Variance. Error có thể được hiểu là tỷ lệ nhầm lẫn dự đoán của mô hình, bao gồm hai phần, một phần là ước tính không chính xác do mô hình quá đơn giản (Bias) và phần khác là không gian thay đổi và không chắc chắn lớn hơn do mô hình quá phức tạp (Variance).

Vì vậy, nó dễ dàng phân tích một Bayes đơn giản. Nó giả định đơn giản rằng các dữ liệu không liên quan, một mô hình được đơn giản hóa nghiêm trọng. Vì vậy, đối với một mô hình đơn giản như vậy, trong hầu hết các trường hợp, phần Bias sẽ lớn hơn phần Variance, tức là độ lệch cao và độ chênh lệch thấp.

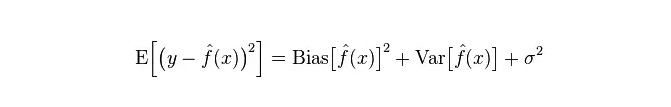

Trong thực tế, để giảm thiểu Error, chúng ta cần cân bằng tỷ lệ của Bias và Variance khi chọn mô hình, tức là cân bằng over-fitting và under-fitting.

Mối quan hệ giữa độ lệch và chênh lệch vuông với độ phức tạp của mô hình được thể hiện rõ hơn bằng cách sử dụng biểu đồ dưới đây:

Khi độ phức tạp của mô hình tăng lên, độ lệch sẽ dần trở nên nhỏ hơn và độ lệch sẽ dần trở nên lớn hơn.

-

Điểm mạnh và nhược điểm của các thuật toán phổ biến

- ### 1. Naughty Bayes

Các mô hình Bayes đơn giản thuộc mô hình sinh nạp (về mô hình sinh nạp và mô hình phân định, chủ yếu là về việc có yêu cầu phân phối chung hay không), rất đơn giản, bạn chỉ cần làm một loạt các phép tính.

Nếu giả định độc lập có điều kiện ((một điều kiện nghiêm ngặt hơn), bộ phân loại Bayes đơn giản sẽ kết hợp nhanh hơn các mô hình phân định, chẳng hạn như logic regression, vì vậy bạn chỉ cần ít dữ liệu đào tạo hơn. Ngay cả khi giả định độc lập có điều kiện NB không thành công, bộ phân loại NB vẫn hoạt động tốt trong thực tế.

Hạn chế chính của nó là nó không thể học được sự tương tác giữa các nhân vật, và R trong mRMR là tính năng dư thừa. Một ví dụ điển hình hơn là, mặc dù bạn thích phim của Brad Pitt và Tom Cruise, nhưng nó không thể học được những bộ phim mà bạn không thích khi họ đóng cùng nhau.

Ưu điểm:

Mô hình Bayes đơn giản bắt nguồn từ lý thuyết toán học cổ điển, có nền tảng toán học vững chắc và hiệu quả phân loại ổn định. Hiệu suất tốt đối với dữ liệu quy mô nhỏ, có thể xử lý các nhiệm vụ đa lớp một cách đơn lẻ, phù hợp với đào tạo gia tăng; Các thuật toán cũng đơn giản hơn, thường được sử dụng để phân loại văn bản. Nhược điểm:

Cần tính toán xác suất trước; Tỷ lệ lỗi trong các quyết định phân loại; Dữ liệu đầu vào rất nhạy cảm với biểu thức.

- ### 2. logic regression

Trong mô hình phân biệt, có rất nhiều phương pháp để chuẩn hóa mô hình (L0, L1, L2, v.v.), và bạn không cần phải lo lắng về tính chất của bạn có liên quan hay không như trong mô hình Bayes đơn giản.

Bạn cũng sẽ có một giải thích xác suất tốt hơn so với cây quyết định và máy SVM, và bạn thậm chí có thể dễ dàng sử dụng dữ liệu mới để cập nhật mô hình (thông dụng thuật toán giảm độ dốc trực tuyến, online gradient descent).

Nếu bạn cần một cấu trúc xác suất (ví dụ, đơn giản là điều chỉnh các ngưỡng phân loại, chỉ ra sự không chắc chắn, hoặc để có được khoảng tin cậy), hoặc bạn muốn tích hợp dữ liệu đào tạo nhiều hơn vào mô hình một cách nhanh chóng sau này, hãy sử dụng nó.

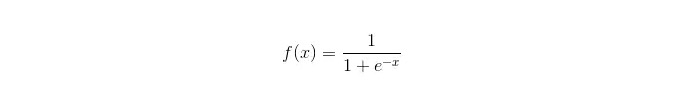

Hàm sigmoid:

Ưu điểm: Đơn giản, được áp dụng rộng rãi cho các vấn đề công nghiệp; Lượng tính toán rất nhỏ, tốc độ nhanh và ít tài nguyên lưu trữ khi phân loại; Điểm số xác suất mẫu quan sát thuận tiện; Đối với logical regression, đa đồng tuyến tính không phải là vấn đề, nó có thể được giải quyết bằng cách kết hợp với chính quy hóa L2; Nhược điểm: Logical regression không hoạt động tốt khi có một không gian đặc trưng lớn. Dễ bị thiếu phù hợp, thường không chính xác Không thể xử lý tốt một lượng lớn các đặc điểm hoặc biến đa dạng; Chỉ có thể xử lý hai câu hỏi phân loại (softmax được phát sinh từ đó có thể được sử dụng cho nhiều phân loại) và phải phân chia theo đường thẳng; Đối với các đặc điểm phi tuyến tính, cần phải chuyển đổi;

- ### 3. Phục hồi tuyến tính

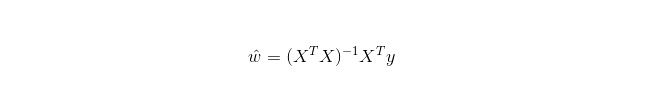

Phục hồi tuyến tính được sử dụng để hồi quy, không giống như Phục hồi Logistic được sử dụng để phân loại, ý tưởng cơ bản của nó là sử dụng phương pháp giảm độ bậc để tối ưu hóa hàm sai lệch dưới dạng phép nhân đôi nhỏ nhất, và tất nhiên cũng có thể sử dụng phương trình bình thường để giải quyết các tham số trực tiếp, kết quả là:

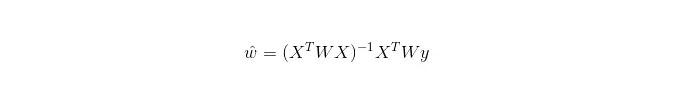

Trong LWLR, biểu thức tính toán của tham số là:

Điều này cho thấy rằng LWLR khác với LR, LWLR là một mô hình không tham số, vì mỗi lần tính toán hồi quy phải đi qua mẫu đào tạo ít nhất một lần.

Ưu điểm: Dễ thực hiện, tính toán đơn giản;

Hạn chế: Không phù hợp với dữ liệu phi tuyến tính.

- ### 4. Thuật toán gần gũi nhất

KNN là thuật toán gần gũi, quy trình chính của nó là:

Tính toán khoảng cách của mỗi điểm lấy mẫu trong mẫu huấn luyện và mẫu thử nghiệm (các thước đo khoảng cách phổ biến là khoảng cách theo phương trình Euler, khoảng cách theo phương trình Mars, v.v.)

Lưu ý rằng các giá trị khoảng cách trên được sắp xếp theo thứ tự.

K mẫu có khoảng cách tối thiểu trước khi chọn;

Sau đó, các mẫu mẩu được bỏ phiếu dựa trên các nhãn, và kết quả là một danh mục phân loại cuối cùng.

Làm thế nào để chọn một giá trị K tối ưu phụ thuộc vào dữ liệu. Thông thường, một giá trị K lớn hơn trong phân loại có thể làm giảm tác động của tiếng ồn. Nhưng nó có thể làm mờ ranh giới giữa các loại.

Một giá trị K tốt hơn có thể được thu thập thông qua các kỹ thuật mở rộng khác nhau, chẳng hạn như xác minh chéo. Ngoài ra, sự hiện diện của các vector đặc tính tiếng ồn và không liên quan làm giảm độ chính xác của thuật toán cận k.

Thuật toán gần gũi có kết quả thống nhất mạnh mẽ. Khi dữ liệu tiến đến vô hạn, thuật toán đảm bảo không có tỷ lệ lỗi lớn hơn gấp đôi tỷ lệ lỗi của thuật toán Bayesian. Đối với một số giá trị K tốt, K gần gũi đảm bảo không có tỷ lệ lỗi lớn hơn tỷ lệ lỗi của lý thuyết Bayesian.

Ưu điểm của KNN

Lý thuyết đã trưởng thành, ý tưởng đơn giản, có thể được sử dụng để phân loại và cũng có thể được sử dụng để hồi quy; Có thể sử dụng phân loại phi tuyến tính; độ phức tạp thời gian đào tạo là O ((n); Không có giả định về dữ liệu, có độ chính xác cao và không nhạy cảm với các outlier; khuyết điểm

Số lượng lớn. Vấn đề không cân bằng mẫu (ví dụ, một số loại có rất nhiều mẫu trong khi số lượng mẫu khác ít); Dùng rất nhiều bộ nhớ;

- ### 5. Cây quyết định

Dễ dàng giải thích. Nó có thể xử lý các mối quan hệ tương tác giữa các đặc điểm một cách không căng thẳng và không tham số, vì vậy bạn không cần phải lo lắng về giá trị bất thường hoặc dữ liệu có thể phân tách theo đường tuyến hay không (ví dụ, cây quyết định có thể dễ dàng xử lý trường hợp loại A ở cuối một chiều x đặc điểm, loại B ở giữa, và sau đó loại A xuất hiện ở đầu chiều x đặc điểm).

Một trong những nhược điểm của nó là nó không hỗ trợ học tập trực tuyến, vì vậy cây quyết định cần phải được xây dựng lại hoàn toàn khi mẫu mới đến.

Một nhược điểm khác là dễ bị quá phù hợp, nhưng đây cũng là điểm cắt của các phương pháp tích hợp như RF rừng ngẫu nhiên (hoặc nâng cao cây được tăng cường).

Ngoài ra, rừng ngẫu nhiên thường là người chiến thắng trong nhiều vấn đề phân loại (thường là một chút tốt hơn máy vector hỗ trợ), nó được đào tạo nhanh chóng và có thể điều chỉnh, và bạn không phải lo lắng về việc điều chỉnh một loạt các tham số như máy vector hỗ trợ, vì vậy nó đã rất phổ biến trước đây.

Một điểm quan trọng trong cây quyết định là chọn một thuộc tính để phân nhánh, vì vậy hãy chú ý đến công thức tính toán của gia tăng thông tin và hiểu sâu hơn về nó.

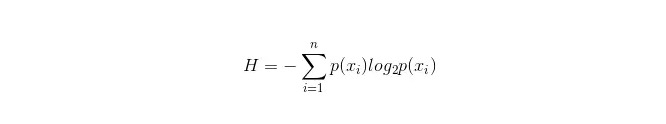

Công thức tính toán của thông tin là:

Trong đó, n đại diện cho n loại phân loại ((như giả sử là câu hỏi loại 2, thì n = 2) ◄ tính toán khả năng p1 và p2 của hai loại mẫu xuất hiện trong tổng mẫu, để có thể tính toán thông tin trước khi phân nhánh thuộc tính không được chọn ◄ .

Bây giờ chọn một thuộc tính xxi để phân nhánh, tại thời điểm này quy tắc phân nhánh là: nếu xxi = vxi = v, hãy phân chia mẫu vào một nhánh của cây; nếu không bằng nhau, hãy vào nhánh khác.

Rõ ràng, mẫu trong nhánh rất có thể bao gồm 2 loại, tính riêng các hàm H1 và H2 của 2 nhánh, tính tổng thông tin sau khi phân nhánh H = p1 H1 + p2 H2, thì tăng thông tin tại thời điểm này ΔH = H - H. Sử dụng tăng thông tin làm nguyên tắc, kiểm tra tất cả các thuộc tính một bên, chọn một thuộc tính tăng lớn nhất làm thuộc tính phân nhánh lần này.

Những ưu điểm của cây quyết định

Tính toán đơn giản, dễ hiểu và có thể giải thích được; so sánh các mẫu phù hợp với xử lý các thuộc tính bị thiếu; Có khả năng xử lý các đặc điểm không liên quan; Trong một thời gian tương đối ngắn, có thể đưa ra kết quả khả thi và hiệu quả đối với các nguồn dữ liệu lớn. khuyết điểm

Dễ bị quá phù hợp (các khu rừng ngẫu nhiên có thể giảm quá phù hợp); Không có sự liên quan giữa các dữ liệu. Đối với các loại dữ liệu với số lượng mẫu không nhất quán, trong cây quyết định, kết quả của gia tăng thông tin thiên vị đối với những đặc điểm có giá trị số nhiều hơn (còn có một nhược điểm khi sử dụng gia tăng thông tin, chẳng hạn như RF).

- ### 5.1 Adaboosting

Adaboost là một mô hình tổng hợp, mỗi mô hình được xây dựng dựa trên tỷ lệ lỗi của mô hình trước đó, tập trung quá nhiều vào các mẫu bị phân loại sai, và giảm sự chú ý đến các mẫu được phân loại đúng, sau khi lặp đi lặp lại, có thể có một mô hình tương đối tốt. Đây là một thuật toán tăng cường điển hình.

lợi thế

Adaboost là một phân loại có độ chính xác cao. Có nhiều cách để xây dựng phân loại con, Adaboost cung cấp một khung. Khi sử dụng phân loại đơn giản, kết quả tính toán có thể hiểu được và cấu trúc của phân loại yếu rất đơn giản. Đơn giản, không cần lọc đặc điểm. Không dễ bị overfitting. Về các thuật toán kết hợp như rừng ngẫu nhiên và GBDT, tham khảo bài viết này: Machine Learning - Summary of Combinator Algorithms

Nhược điểm: nhạy cảm với outlier

- ### 6. Máy vector hỗ trợ SVM

Tính chính xác cao, cung cấp đảm bảo lý thuyết tốt để tránh quá phù hợp, và nó hoạt động tốt ngay cả khi dữ liệu không thể phân tách được theo đường tuyến tính trong không gian đặc trưng ban đầu, chỉ cần cho một hàm lõi phù hợp.

Trong các vấn đề phân loại văn bản có độ phân giải siêu cao. Thật không may là bộ nhớ tiêu tốn rất nhiều, khó giải thích, vận hành và tham khảo cũng có một số khó khăn, và rừng ngẫu nhiên đã tránh được những nhược điểm này, thực tế hơn.

lợi thế Nó có thể giải quyết các vấn đề về chiều cao, không gian đặc trưng lớn. Có thể xử lý các tương tác của các đặc điểm phi tuyến tính; Không cần phải dựa vào toàn bộ dữ liệu. Có thể tăng khả năng phổ biến;

khuyết điểm Khi quan sát nhiều mẫu, hiệu quả không cao; Không có giải pháp chung cho các vấn đề phi tuyến tính, và đôi khi rất khó để tìm một hàm hạt nhân phù hợp. Nhận thức được dữ liệu bị thiếu; Lựa chọn của kernel cũng rất khéo léo (libsvm có bốn hàm kernel: kernel tuyến tính, kernel đa dạng, kernel RBF và kernel sigmoid):

Thứ nhất, nếu số lượng mẫu nhỏ hơn số tính năng, thì không cần phải chọn lõi phi tuyến tính, chỉ cần sử dụng lõi tuyến tính.

Thứ hai, nếu số lượng mẫu lớn hơn số tính năng, thì có thể sử dụng lõi phi tuyến tính để lập bản đồ mẫu lên chiều cao hơn, thường có kết quả tốt hơn;

Thứ ba, nếu số lượng mẫu và số lượng đặc điểm bằng nhau, trường hợp này có thể sử dụng lõi phi tuyến tính, nguyên tắc giống như loại thứ hai.

Đối với trường hợp đầu tiên, bạn có thể giảm kích thước dữ liệu trước và sau đó sử dụng lõi phi tuyến tính, đây cũng là một phương pháp.

- ### Lợi ích và bất lợi của mạng thần kinh nhân tạo

Những lợi ích của mạng thần kinh nhân tạo: Phân loại chính xác; Có khả năng xử lý phân tán song song, có khả năng lưu trữ và học tập phân tán. Có tính thô lỗ và khả năng chấp nhận lỗi mạnh mẽ đối với các dây thần kinh tiếng ồn, có thể tiếp cận đầy đủ các mối quan hệ phi tuyến tính phức tạp; Có chức năng nhớ liên kết.

Những điểm yếu của mạng thần kinh nhân tạo: Mạng thần kinh đòi hỏi một số lượng lớn các tham số, chẳng hạn như cấu trúc topology mạng, giá trị trọng lượng và giá trị threshold đầu tiên; Không thể quan sát được quá trình học tập, các kết quả đầu ra khó giải thích, ảnh hưởng đến độ tin cậy và khả năng chấp nhận kết quả; Học tập quá lâu và thậm chí có thể không đạt được mục đích học tập.

- ### 8 K-Means cluster

Một bài viết trước đây đã viết về K-Means cluster, có một ý tưởng EM mạnh mẽ về K-Means.

lợi thế Các thuật toán đơn giản và dễ thực hiện. Đối với các tập dữ liệu lớn, thuật toán này tương đối có thể mở rộng và hiệu quả cao, vì độ phức tạp của nó là khoảng O{\displaystyle O} nkt, trong đó n là số lượng tất cả các đối tượng, k là số n ∈ N, t là số lần lặp. Thông thường k<

khuyết điểm Các yêu cầu về loại dữ liệu cao hơn, phù hợp với dữ liệu dạng số; Có thể kết hợp các giá trị nhỏ nhất tại địa phương, kết hợp chậm hơn trên dữ liệu lớn Các giá trị K khó có thể lấy được; Nhận thức được các giá trị trung tâm của giá trị ban đầu, có thể dẫn đến kết quả cụm khác nhau cho các giá trị ban đầu khác nhau; Không thích hợp cho việc phát hiện các hình dạng không vòm, hoặc các hình dạng khác nhau về kích thước. Một lượng nhỏ các loại dữ liệu này có thể ảnh hưởng rất lớn đến giá trị trung bình.

Thuật toán chọn tham chiếu

Một bài viết trước đây đã dịch một số bài viết từ nước ngoài, trong đó có một bài viết cho một thuật toán đơn giản để chọn một bài viết:

Lựa chọn đầu tiên là logical regression, nếu hiệu quả của nó không tốt, thì kết quả của nó có thể được sử dụng làm chuẩn mực để so sánh với các thuật toán khác;

Sau đó thử nghiệm cây quyết định ((rừng ngẫu nhiên) để xem liệu có thể nâng cao hiệu suất mô hình của bạn một cách đáng kể không. Ngay cả khi bạn không coi nó là mô hình cuối cùng, bạn cũng có thể sử dụng rừng ngẫu nhiên để loại bỏ các biến tiếng ồn, để lựa chọn đặc điểm;

Nếu số lượng đặc điểm và mẫu quan sát đặc biệt nhiều, thì khi có đủ nguồn lực và thời gian (điều này rất quan trọng), sử dụng SVM là một lựa chọn.

Thông thường: GBDT>=SVM>=RF>=Adaboost>=Other… , bây giờ học tập sâu rất phổ biến, nhiều lĩnh vực được sử dụng, nó dựa trên mạng thần kinh, hiện tại tôi cũng đang học, chỉ là kiến thức lý thuyết không quá dày, hiểu không đủ sâu, không giới thiệu ở đây.

Thuật toán là quan trọng, nhưng dữ liệu tốt sẽ tốt hơn thuật toán tốt, thiết kế các tính năng tốt là rất có lợi. Nếu bạn có một bộ dữ liệu rất lớn, thì bất cứ thuật toán nào bạn sử dụng có thể không ảnh hưởng nhiều đến hiệu suất phân loại (bây giờ bạn có thể lựa chọn dựa trên tốc độ và khả năng sử dụng).

-

Tài liệu tham khảo