Python 朴素贝叶斯 应用

0

0

2220

2220

Python 朴素贝叶斯 应用

在预示变量间相互独立的前提下,根据贝叶斯定理可以得到朴素贝叶斯这个分类方法。用更简单的话来说,一个朴素贝叶斯分类器假设一个分类的特性与该分类的其它特性不相关。举个例子,如果一个水果又圆又红,并且直径大约是 3 英寸,那么这个水果可能会是苹果。即便这些特性互相依赖,或者依赖于别的特性的存在,朴素贝叶斯分类器还是会假设这些特性分别独立地暗示这个水果是个苹果。

- #### 朴素贝叶斯模型易于建造,且对于大型数据集非常有用。虽然简单,但是朴素贝叶斯的表现却超越了非常复杂的分类方法。

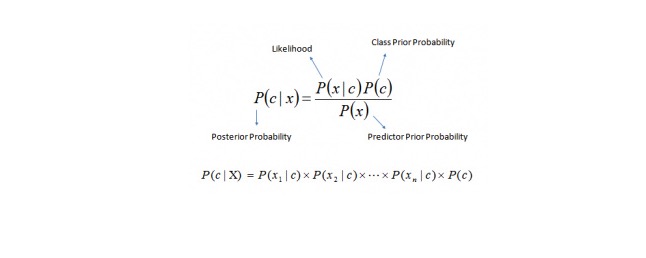

贝叶斯定理提供了一种从P©、P(x)和P(x|c) 计算后验概率 P(c|x) 的方法。请看以下等式:

在这里,

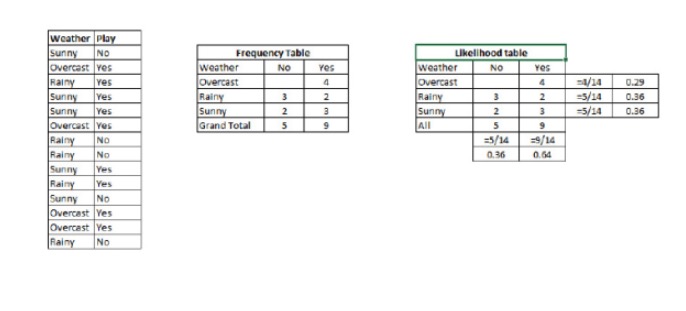

P(c|x) 是已知预示变量(属性)的前提下,类(目标)的后验概率 P© 是类的先验概率 P(x|c) 是可能性,即已知类的前提下,预示变量的概率 P(x) 是预示变量的先验概率 例子:让我们用一个例子来理解这个概念。在下面,我有一个天气的训练集和对应的目标变量“Play”。现在,我们需要根据天气情况,将会“玩”和“不玩”的参与者进行分类。让我们执行以下步骤。

步骤1:把数据集转换成频率表。

步骤2:利用类似“当Overcast可能性为0.29时,玩耍的可能性为0.64”这样的概率,创造 Likelihood 表格。

步骤3:现在,使用朴素贝叶斯等式来计算每一类的后验概率。后验概率最大的类就是预测的结果。

问题:如果天气晴朗,参与者就能玩耍。这个陈述正确吗?

我们可以使用讨论过的方法解决这个问题。于是 P(会玩 | 晴朗)= P(晴朗 | 会玩)* P(会玩)/ P (晴朗)

我们有 P (晴朗 |会玩)= 3⁄9 = 0.33,P(晴朗) = 5⁄14 = 0.36, P(会玩)= 9⁄14 = 0.64

现在,P(会玩 | 晴朗)= 0.33 * 0.64 / 0.36 = 0.60,有更大的概率。

朴素贝叶斯使用了一个相似的方法,通过不同属性来预测不同类别的概率。这个算法通常被用于文本分类,以及涉及到多个类的问题。

- #### Python代码:

#Import Library

from sklearn.naive_bayes import GaussianNB

#Assumed you have, X (predictor) and Y (target) for training data set and x_test(predictor) of test_dataset

# Create SVM classification object model = GaussianNB()

# there is other distribution for multinomial classes like Bernoulli Naive Bayes, Refer link

# Train the model using the training sets and check score

model.fit(X, y)

#Predict Output

predicted= model.predict(x_test)

- 顺势交易与借势交易

- 如何使用 “画线类库” 模板 画出 2 个 Y 轴

- 实盘进行程序化交易需要注意的7个问题

- 希望支持bitmex平台

- 求支持coinbase和itbit

- 求出的macd,请 @小小梦 看下

- 评价算法交易表现的指标---夏普比率

- 一种新型的网格交易法则

- 感觉韭菜都被你们割了 我还是持币好了

- 系统地学习正则表达式(一):基础篇

- 螺纹钢、铁矿石比值交易策略的应用分析

- 要如何分析期权的波动率?

- 程序化在期权的应用

- 时间与周期

- 大脑中的支持向量机

- 聊聊做市商和对赌

- 世上最深的路,就是你的套路:深挖套利江湖的那些“坑”

- 读《概率统计超入门》及《万万没想到之最简单概率论的五个智慧》

- 资金管理三部曲:格局为先

- 能用加法赚钱,我绝不用乘法