Transformer 的金融量化应用

4

4

147

147

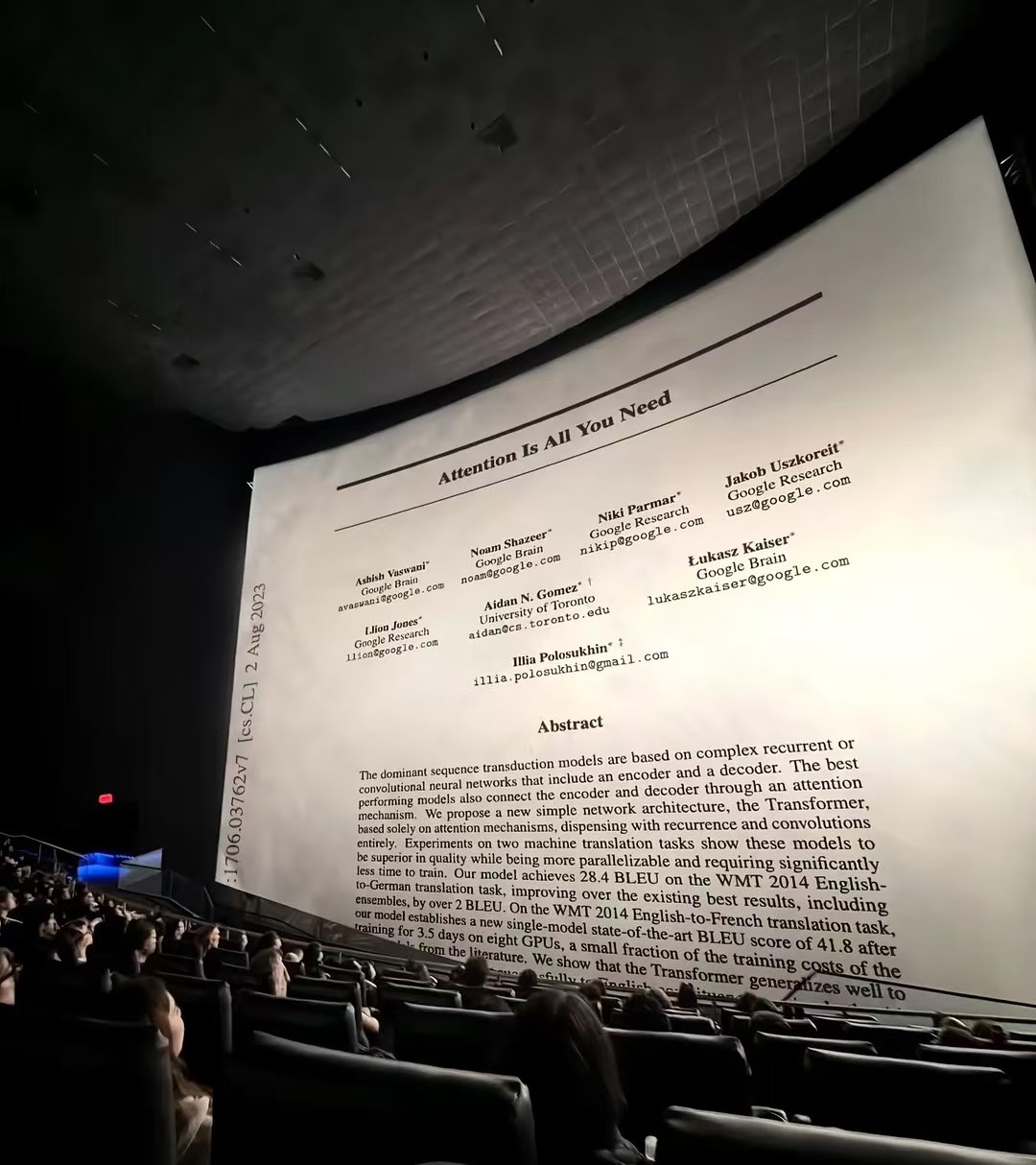

2017年,一篇名为《Attention Is All You Need》的论文横空出世,并在接下来的几年内直至现在制霸了整个生成式AI领域。在这篇具有里程碑和突破性意义的论文中,8名研究学者首次提出了Transformer这种神经网络架构,其独特之处在于完全基于注意力机制,摒弃了传统的循环和卷积操作。通过自注意力机制(self-attention),Transformer能够有效捕捉输入序列中的长距离依赖关系,使得模型在处理长文本时更为高效和准确。多头注意力机制(multi-head attention)则进一步增强了模型的表达能力,使其能够同时关注输入序列中的不同部分,捕捉更加复杂的语义关系。

2017年,一篇名为《Attention Is All You Need》的论文横空出世,并在接下来的几年内直至现在制霸了整个生成式AI领域。在这篇具有里程碑和突破性意义的论文中,8名研究学者首次提出了Transformer这种神经网络架构,其独特之处在于完全基于注意力机制,摒弃了传统的循环和卷积操作。通过自注意力机制(self-attention),Transformer能够有效捕捉输入序列中的长距离依赖关系,使得模型在处理长文本时更为高效和准确。多头注意力机制(multi-head attention)则进一步增强了模型的表达能力,使其能够同时关注输入序列中的不同部分,捕捉更加复杂的语义关系。

Transformer对于金融量化的应用

Transformer的核心创新在于自注意力机制(Self-Attention),它能够捕捉序列中任意两个元素之间的依赖关系,无论它们之间的距离有多远。这一特性使其特别适合处理具有复杂时间依赖关系的金融时间序列数据。

时间序列预测

传统的金融时间序列预测方法(如ARIMA、LSTM)难以捕捉长期依赖关系,而Transformer在这方面表现出色

多因子模型

Transformer可以同时处理数百个因子,自动学习因子间的复杂非线性关系和时变特性 * 因子重要性分析:通过注意力权重识别关键驱动因子

动态因子暴露:捕捉因子有效性的时变特征

风险管理

市场风险建模:

VaR(风险价值)预测:处理极端市场条件下的非线性关系

波动率预测:捕捉波动率集聚效应和杠杆效应

相关性预测:动态资产相关性建模

投资组合优化

Transformer能够处理:

多资产、多频率数据

市场状态识别和预测

基于注意力权重的资产选择 交易执行优化: * 市场冲击建模:预测大额交易对市场的影响

最优执行策略:最小化交易成本

高频交易与市场微观结构

限价订单簿分析 Transformer能够有效处理高频的订单簿数据:

订单流预测:预测买卖订单的不平衡

价格冲击分析:评估大额订单对市场价格的影响

流动性预测:预测市场深度的变化

市场操纵检测

通过分析交易序列模式,识别:

幌骗(Spoofing)行为

拉高出货(Pump and Dump)模式

其他市场操纵行为

实战

Transformer 专门处理 5维的OHLCV时序数据(开盘价、最高价、最低价、收盘价、成交量):

输入形状:(batch_size, seq_len=30, feature_dim=5)

通过学习序列中的时间依赖关系,提取更丰富的时序特征

比简单的技术指标更能捕捉复杂的市场模式

Transformer模型定义 (TimeSeriesTransformer类)

class TimeSeriesTransformer(nn.Module):

def __init__(self, input_dim=5, d_model=32, nhead=4, num_encoder_layers=2, dim_feedforward=64, dropout=0.1, num_classes=3):

super(TimeSeriesTransformer, self).__init__()

self.input_proj = nn.Linear(input_dim, d_model)

encoder_layer = nn.TransformerEncoderLayer(d_model, nhead, dim_feedforward, dropout, batch_first=True)

self.transformer_encoder = nn.TransformerEncoder(encoder_layer, num_encoder_layers)

self.feature_layer = nn.Linear(d_model, d_model) # 用于提取特征

self.classifier = nn.Linear(d_model, num_classes) # 用于Transformer自身的预测(如果需要)

def forward(self, src, return_features=False):

src = self.input_proj(src)

memory = self.transformer_encoder(src)

# 取序列的最后一个时间步的输出作为特征

features = self.feature_layer(memory[:, -1, :])

if return_features:

return features

else:

return self.classifier(features)

数据预处理函数

获取Transformer输入(带scaler)

def get_transformer_input(klines, index):

if index < config.TRANSFORMER_SEQ_LEN - 1:

return torch.zeros(1, config.TRANSFORMER_SEQ_LEN, 5)

# 提取序列数据

start_idx = index - config.TRANSFORMER_SEQ_LEN + 1

end_idx = index + 1

seq_data = klines[start_idx:end_idx]

# 转换为OHLCV数组

ohlcv = np.array([[k["open"], k["high"], k["low"], k["close"], k["volume"]]

for k in seq_data])

# 自动创建并拟合scaler(仅在训练时)

if ModelRegistry.transformer_scaler is None:

ModelRegistry.transformer_scaler = StandardScaler()

if len(klines) > config.TRANSFORMER_SEQ_LEN:

all_ohlcv = np.array([[k["open"], k["high"], k["low"], k["close"], k["volume"]]

for k in klines])

ModelRegistry.transformer_scaler.fit(all_ohlcv)

# 标准化数据

normalized_ohlcv = ModelRegistry.transformer_scaler.transform(ohlcv)

return torch.tensor(normalized_ohlcv, dtype=torch.float32).unsqueeze(0)

获取Transformer输入(固定scaler)

def get_transformer_input_with_fixed_scaler(klines, index, fixed_scaler):

"""使用固定的scaler生成Transformer输入(用于实时预测)"""

seq_data = klines[start_idx:end_idx]

ohlcv = np.array([[k["open"], k["high"], k["low"], k["close"], k["volume"]]

for k in seq_data])

normalized_ohlcv = fixed_scaler.transform(ohlcv)

return torch.tensor(normalized_ohlcv, dtype=torch.float32).unsqueeze(0)

训练中的Transformer相关代码

if config.TRANSFORMER_ENABLED:

Log("开始联合训练Transformer和分类器...")

# 创建Transformer模型

ModelRegistry.transformer_model = TimeSeriesTransformer(

input_dim=5,

d_model=config.TRANSFORMER_D_MODEL,

nhead=config.TRANSFORMER_NHEAD,

num_encoder_layers=config.TRANSFORMER_NUM_LAYERS,

num_classes=3

)

# 优化器和损失函数

optimizer_transformer = torch.optim.Adam(

ModelRegistry.transformer_model.parameters(),

lr=config.TRANSFORMER_LEARNING_RATE

)

criterion_transformer = nn.CrossEntropyLoss()

# 准备Transformer训练数据(避免数据泄露)

X_transformer_sequences = []

y_transformer_sequences = []

for i in range(len(klines_for_transformer_training) - config.PREDICT_HORIZON - config.TRANSFORMER_SEQ_LEN + 1):

# 提取序列

seq_start = i

seq_end = i + config.TRANSFORMER_SEQ_LEN

seq_ohlcv = np.array([[k["open"], k["high"], k["low"], k["close"], k["volume"]]

for k in klines_for_transformer_training[seq_start:seq_end]])

# 标准化

seq_normalized = ModelRegistry.transformer_scaler.transform(seq_ohlcv)

X_transformer_sequences.append(seq_normalized)

# 计算标签(价格变化)

current_kline = klines_for_transformer_training[seq_end - 1]

future_kline = klines_for_transformer_training[seq_end - 1 + config.PREDICT_HORIZON]

# ... 标签计算逻辑 ...

# 训练Transformer模型

for epoch in range(config.TRANSFORMER_TRAIN_EPOCHS):

ModelRegistry.transformer_model.train()

optimizer_transformer.zero_grad()

outputs = ModelRegistry.transformer_model(X_transformer_sequences)

loss = criterion_transformer(outputs, y_transformer_sequences)

loss.backward()

optimizer_transformer.step()

实时预测中的Transformer代码

model_expects_transformer = any("transformer_feat" in name for name in ModelRegistry.feature_names)

if model_expects_transformer:

if config.TRANSFORMER_ENABLED and ModelRegistry.transformer_model and ModelRegistry.transformer_scaler:

# 检查数据是否足够

if len(FeatureStore.klines_1min) >= config.TRANSFORMER_SEQ_LEN:

# 使用固定scaler获取输入

transformer_input = get_transformer_input_with_fixed_scaler(

FeatureStore.klines_1min,

len(FeatureStore.klines_1min) - 1,

ModelRegistry.transformer_scaler # 使用训练好的scaler

)

# 提取Transformer特征

with torch.no_grad():

transformer_feature_np = ModelRegistry.transformer_model(

transformer_input,

return_features=True

).squeeze(0).numpy()

else:

# 数据不足时使用零填充

transformer_feature_np = np.zeros(config.TRANSFORMER_D_MODEL)

else:

# 配置禁用或模型丢失时使用零填充

transformer_feature_np = np.zeros(config.TRANSFORMER_D_MODEL)

# 特征拼接

if transformer_feature_np is not None:

transformer_cols = [f"transformer_feat_{i}" for i in range(config.TRANSFORMER_D_MODEL)]

transformer_df = pd.DataFrame(transformer_feature_np.reshape(1, -1), columns=transformer_cols)

# 合并表格特征和Transformer特征

final_features_for_model_df = pd.concat([scaled_features_df, transformer_df], axis=1)

模型保存和加载

保存Transformer模型:

if config.TRANSFORMER_ENABLED and ModelRegistry.transformer_model:

transformer_path = os.path.join(config.MODEL_DIR, f"transformer_model_{version}.pth")

torch.save(ModelRegistry.transformer_model.state_dict(), transformer_path)

# 同时保存scaler

transformer_scaler_path = os.path.join(config.MODEL_DIR, f"transformer_scaler_{version}.pkl")

with open(transformer_scaler_path, 'wb') as f:

pickle.dump(ModelRegistry.transformer_scaler, f)

加载Transformer模型:

if config.TRANSFORMER_ENABLED:

transformer_path = os.path.join(config.MODEL_DIR, f"transformer_model_{ModelRegistry.current_model_version}.pth")

if os.path.exists(transformer_path):

ModelRegistry.transformer_model = TimeSeriesTransformer(

input_dim=5,

d_model=config.TRANSFORMER_D_MODEL,

nhead=config.TRANSFORMER_NHEAD,

num_encoder_layers=config.TRANSFORMER_NUM_LAYERS,

num_classes=3

)

ModelRegistry.transformer_model.load_state_dict(torch.load(transformer_path))

ModelRegistry.transformer_model.eval()

# 加载scaler

transformer_scaler_path = os.path.join(config.MODEL_DIR, f"transformer_scaler_{ModelRegistry.current_model_version}.pkl")

with open(transformer_scaler_path, "rb") as f:

ModelRegistry.transformer_scaler = pickle.load(f)

配置参数

self.TRANSFORMER_ENABLED = self.config["transformer"]["enabled"] # 是否启用

self.TRANSFORMER_SEQ_LEN = self.config["transformer"]["seq_len"] # 序列长度(30)

self.TRANSFORMER_D_MODEL = self.config["transformer"]["d_model"] # 特征维度(32)

self.TRANSFORMER_NHEAD = self.config["transformer"]["nhead"] # 注意力头数(4)

self.TRANSFORMER_NUM_LAYERS = self.config["transformer"]["num_layers"] # 层数(2)

self.TRANSFORMER_TRAIN_EPOCHS = self.config["transformer"]["train_epochs"] # 训练轮数

self.TRANSFORMER_LEARNING_RATE = self.config["transformer"]["learning_rate"] # 学习率

特征名称管理

def update_feature_names_with_transformer():

"""更新特征名称列表以包含Transformer特征"""

base_features = [...] # 29个基础特征

if config.TRANSFORMER_ENABLED:

transformer_features = [f"transformer_feat_{i}" for i in range(config.TRANSFORMER_D_MODEL)]

ModelRegistry.feature_names = base_features + transformer_features

else:

ModelRegistry.feature_names = base_features # 仅29个特征

Transformer工作流程

实时预测时:

1. 获取最近30根K线的OHLCV数据 → (30, 5)

2. 使用训练时确定的scaler标准化 → 标准化后的(30, 5)

3. 输入Transformer模型 → 提取32维特征向量

4. 与29维表格特征拼接 → 61维特征向量

5. 输入LightGBM进行最终预测

6. 输出:上涨/下跌/盘整的概率分布

总结

Transformer模型为金融领域带来了革命性的变化,其强大的序列建模能力特别适合金融时间序列分析。从量化交易到风险管理,从另类数据分析到投资组合优化,Transformer正在重塑金融科技的各个领域。

然而,成功应用Transformer需要深入理解金融市场的特殊性,包括数据的非平稳性、信号的噪声性以及监管的复杂性。未来,随着模型可解释性的提高、计算效率的优化和金融领域专用架构的发展,Transformer有望在金融领域发挥更大的价值。

- Inventor Quant Workflow FAQ (Continuously Updated)

- 发明者量化工作流常见问题解答(持续更新)

- 市价单下单都出问题?

- 现在ai确实好用,方便我这种没学过写代码的人快速入手,但我让ai反复写的代码为何一直不能出现参数面板呢?

- 有没有人帮我优化策略,有偿

- 有偿开发一套全仓的网格对冲

- 回测不支持“币安人生”?

- 一种类似于网格的高收益小回撤策略

- 用Python搭建AI量化交易系统(LightGBM+Transformer混合策略)

- 永续无限合约网格多空双向持仓下单精度和执行交易混乱的问题,弄了半个月了实在不会了,有偿求解决办法。各位大佬

- TA.跟talib.计算的结果不一样,有大佬知道原因吗?

- 砍手风控,控制不了自己手

- 币安Python限价止盈止损订单

- 发明者平台盈透证券模拟账户配置方法

- 说一说我自己这些年的交易心得

- 请问KLineChat的副图如何设置精度?

- 关于用手机修改代码的问题

- 胜率60以上。

- ai策略大家都在使用什么?