Bayes - Das Geheimnis der Wahrscheinlichkeit entschlüsseln und die mathematische Weisheit der Entscheidungsfindung erforschen

Schriftsteller:Lydia., Erstellt: 2023-11-27 11:55:42, Aktualisiert: 2024-01-01 12:20:59

Bayesische Statistik ist eine mächtige Disziplin im Bereich der Mathematik, mit breiten Anwendungen in vielen Bereichen, darunter Finanzen, medizinische Forschung und Informationstechnologie.

In diesem Artikel stellen wir einige der wichtigsten Mathematiker vor, die dieses Feld gegründet haben.

Vor Bayes Um die bayesische Statistik besser zu verstehen, müssen wir ins 18. Jahrhundert zurückgehen und uns auf den Mathematiker De Moivre und seine Arbeit "The Doctrine of Chances" beziehen.

Wie Sie vielleicht wissen, führte seine Lösung eines dieser Probleme zur Entstehung der Normalverteilung, aber das ist eine andere Geschichte.

Eine der einfachsten Fragen in seiner Arbeit lautete:

Wenn Sie die in "The Doctrine of Chances" beschriebenen Probleme durchlesen, werden Sie vielleicht feststellen, dass die meisten mit einer Annahme beginnen, aus der sie die Wahrscheinlichkeiten für bestimmte Ereignisse berechnen.

Dies würde heute mathematisch so ausgedrückt werden:

Formeln

𝑃(𝑋|𝜃)

Was aber, wenn wir nicht wissen, ob die Münze fair ist?𝜃 ?

Thomas Bayes und Richard Price

Fast fünfzig Jahre später, im Jahre 1763, wurde in den Philosophical Transactions der Royal Society of London ein Papier mit dem Titel

In den ersten Seiten dieses Dokuments gibt es ein Stück, das der Mathematiker Richard Price geschrieben hat, das eine Arbeit zusammenfasst, die sein Freund Thomas Bayes einige Jahre vor seinem Tod schrieb.

Tatsächlich verwies er auf ein spezifisches Problem:

Mit anderen Worten, nachdem wir ein Ereignis beobachtet haben, bestimmen wir, was die Wahrscheinlichkeit ist, dass ein unbekannter ParameterθDies ist tatsächlich eines der ersten Probleme im Zusammenhang mit der statistischen Inferenz in der Geschichte und es führte zum Begriff inverse Wahrscheinlichkeit.

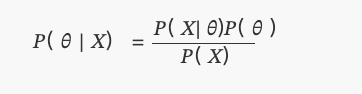

Formeln

𝑃( 𝜃 | 𝑋)

Das ist natürlich das, was wir heute die Hinterverteilung des Bayes

Aus Gründen ohne Ursache und Wirkung

Die Motivation hinter der Forschung dieser beiden älteren Prediger zu verstehen,Thomas BayesundRichard PriceAber um das zu tun, müssen wir vorübergehend einige Kenntnisse über Statistik beiseite legen.

Wir befinden uns im 18. Jahrhundert, in dem Wahrscheinlichkeit zu einem immer interessanteren Feld für Mathematiker wird. Mathematiker wie de Moivre oder Bernoulli haben bereits gezeigt, dass einige Ereignisse mit einem gewissen Grad an Zufälligkeit auftreten, aber immer noch durch feste Regeln geregelt werden. Zum Beispiel, wenn Sie einen Würfel mehrmals werfen, wird ein Sechstel der Zeit auf sechs landen. Es ist, als ob es eine versteckte Regel gibt, die die Schicksalschancen bestimmt.

Stellen Sie sich nun vor, Sie wären ein Mathematiker und ein gläubiger Gläubiger, der in dieser Zeit lebt.

Diese Frage stellten Bayes und Price selbst. Sie hofften, dass ihre Lösung direkt darauf anwendbar wäre, zu beweisen, dass die Welt das Ergebnis von Weisheit und Intelligenz sein muss; und somit Beweise für die Existenz Gottes als letztendliche Ursache liefern - das heißt, eine Ursache ohne Kausalität.

Laplace

Überraschenderweise schrieb der französische Mathematiker Laplace ungefähr zwei Jahre später, 1774, ohne Thomas Bayes' Papier gelesen zu haben, ein Papier mit dem Titel "Über die Ursachen von Ereignissen durch Wahrscheinlichkeit von Ereignissen", das sich mit inversen Wahrscheinlichkeitsproblemen befasst.

Das ist das, was wir heute als Bayes

Wo ist er?P(θ)ist eine gleichmäßige Verteilung.

Münzexperiment

Wir werden Bayes-Statistiken in die Gegenwart bringen, indem wir Python und PyMC-Bibliothek verwenden und ein einfaches Experiment durchführen.

Angenommen, ein Freund gibt Ihnen eine Münze und fragt, ob Sie denken, dass es eine faire Münze ist. Weil er es eilig hat, sagt er Ihnen, dass Sie die Münze nur 10 Mal werfen können. Wie Sie sehen können, gibt es einen unbekannten Parameterpin diesem Problem, die die Wahrscheinlichkeit ist, Köpfe in Münzwerfen zu bekommen, und wir wollen den wahrscheinlichsten Wert derp.

(Anmerkung: Wir sagen nicht, dass Parameterpist eine zufällige Variable, sondern dass dieser Parameter fixiert ist; wir wollen wissen, wo es am wahrscheinlichsten ist.)

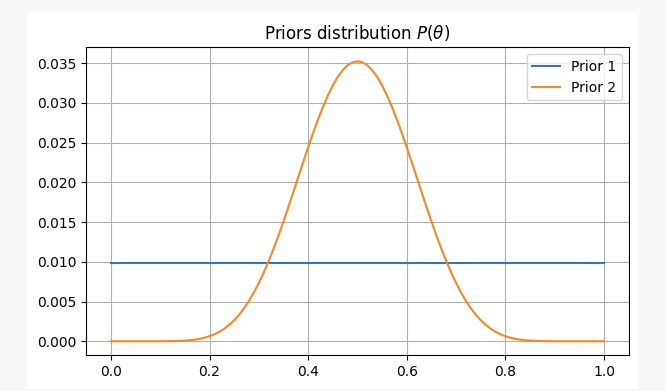

Um verschiedene Ansichten zu diesem Problem zu haben, werden wir es unter zwei verschiedenen Vorurteilen lösen:

-

- Sie haben keine vorherigen Informationen über die Fairness der Münze, so dass Sie eine gleiche Wahrscheinlichkeit zuordnen

pIn diesem Fall verwenden wir ein sogenanntes nicht-informatives Vorhergehen, weil Sie Ihren Überzeugungen keine Informationen hinzugefügt haben.

- Sie haben keine vorherigen Informationen über die Fairness der Münze, so dass Sie eine gleiche Wahrscheinlichkeit zuordnen

-

- Aus eigener Erfahrung wissen Sie, dass es, auch wenn eine Münze unfair sein mag, schwer ist, sie extrem unfair zu machen.

pIn diesem Fall verwenden wir einen informativen Prior.

- Aus eigener Erfahrung wissen Sie, dass es, auch wenn eine Münze unfair sein mag, schwer ist, sie extrem unfair zu machen.

Für diese beiden Szenarien sind unsere vorherigen Überzeugungen wie folgt:

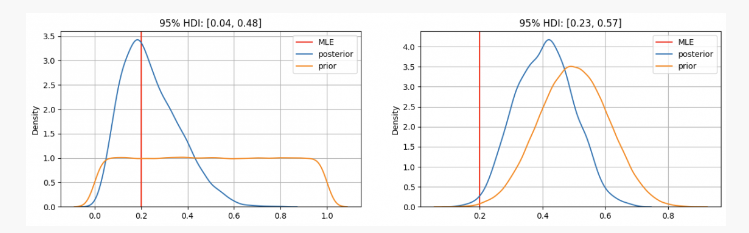

Mit diesen Beweisen, wo sind wir wahrscheinlich unseren Parameter zu findenp?

Wie Sie sehen können, im ersten Fall, unsere vorherige Verteilung von Parameterpwird bei der Höchstwahrscheinlichkeitsschätzung (MLE) konzentriertp=0.2Der wahre unbekannte Parameter liegt im Konfidenzintervall von 95% zwischen 0,04 und 0,48.

Auf der anderen Seite ist in Fällen, in denen ein hohes Vertrauen besteht, dass der ParameterpWir können sehen, dass die Hinterverteilung ungefähr 0,4 beträgt, viel höher als das, was unsere MLE uns gibt.

Daher würden Sie in dem ersten Fall Ihrem Freund mit Sicherheit sagen, dass diese Münze nicht fair ist, aber in einer anderen Situation würden Sie sagen, dass es unsicher ist, ob sie fair ist oder nicht.

Wie Sie sehen können, können auch bei identischen Beweisen (zwei Köpfe von zehn Würfen) unter verschiedenen vorherigen Überzeugungen die Ergebnisse stark variieren; ein Vorteil der bayesischen Statistik gegenüber traditionellen Methoden liegt hier: Wie die wissenschaftliche Methodik ermöglicht es uns, unsere Überzeugungen zu aktualisieren, indem wir sie mit neuen Beobachtungen und Beweisen kombinieren.

Ende

Im heutigen Artikel haben wir die Ursprünge der bayesischen Statistik und ihre wichtigsten Mitwirkenden gesehen.quantdare.com.

- FMZ-Quantifizierung: Analyse von Designbeispielen für häufige Bedürfnisse im Kryptowährungsmarkt

- WexApp, die FMZ Quant Cryptocurrency Demo Exchange, ist neu gestartet

- Detaillierte Erläuterung der Optimierung von Perpetual Contract Grid Strategy Parametern

- Wie man die FMZ-Erweiterte API verwendet, um die Parameter des Bots zu ändern

- Wie man die Festplattenparameter mit der FMZ-Erweiterungs-API in großen Mengen modifiziert

- Optimierung von Parametern für die Strategie eines dauerhaften Vertragsnetzes

- Anweisungen zur Installation von Interactive Brokers IB Gateway in Linux Bash

- Installation von Penetration Securities IB GATEWAY unter Linux bash

- Was ist besser für die Unterfischung, ein niedriger Marktwert oder ein niedriger Preis?

- Was ist besser für einen Übersetzer, wenn der Marktwert niedrig oder der Preis niedrig ist?

- Bayes - Das Geheimnis der Wahrscheinlichkeitsentwicklung und die mathematische Intelligenz hinter Entscheidungen

- Die Vorteile der Nutzung der erweiterten API von FMZ für ein effizientes Gruppenkontrollmanagement im quantitativen Handel

- Preisentwicklung nach Notierung der Währung in dauerhaften Verträgen

- Effiziente Cluster-Management-Vorteile bei quantitativen Transaktionen mit FMZs erweiterten API

- Preisentwicklung nach der Einführung eines dauerhaften Kontracts

- Der Zusammenhang zwischen dem Anstieg und Fall von Währungen und Bitcoin

- Relation zwischen dem Kursverfall und Bitcoin

- Eine kurze Diskussion über die Balance der Auftragsbücher in zentralisierten Börsen

- Messen von Risiko und Rendite - Einführung in die Markowitz-Theorie

- Ein Gespräch über die Auftragsbuchbilanz der zentralen Börse