Máquinas de vectores de soporte en el cerebro

0

0

2056

2056

Máquinas de vectores de soporte en el cerebro

La máquina vectorial de soporte (SVM) es un clasificador de aprendizaje de máquina importante, que utiliza una ingeniosa transformación no lineal para proyectar características de baja dimensión a alta dimensión, y puede realizar tareas de clasificación más complejas. La SWM parece usar un truco matemático, pero coincide con la mecánica de la codificación del cerebro, que podemos leer en un artículo de Nature de 2013 para comprender la profunda conexión entre el aprendizaje de la máquina y el funcionamiento del cerebro. Título del artículo: La importancia de la selectividad mixta en tareas cognitivas complejas (by Omri Barak al. )

- #### SVM

En primer lugar, hablemos de la naturaleza de la codificación neuronal: los animales reciben una señal y actúan de acuerdo con ella, una de las cuales es la conversión de la señal externa en una señal neuroeléctrica, y la otra es la conversión de la señal neuroeléctrica en una señal de decisión, el proceso anterior se llama codificación, y el siguiente proceso se llama decodificación. El verdadero propósito de la codificación neuronal es decodificar y luego tomar una decisión.

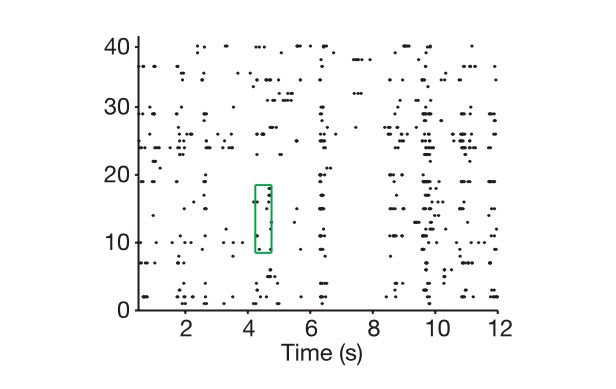

Así que vamos a ver cómo se hace la codificación neuronal. Primero, una neurona es un circuito RC que ajusta la resistencia y la capacidad de la señal externa cuando la señal externa es lo suficientemente grande para conducirla, y de lo contrario, se cierra para representar una señal a través de la frecuencia de emisión en un cierto tiempo.

El diagrama muestra cómo extraemos el código neural de las células en el eje vertical y el tiempo en el eje lateral.

En primer lugar, entramos en este espacio de dimensiones N marcado por un vector de dimensiones N, y luego damos todas las combinaciones posibles de tareas, como por ejemplo, mostrarte mil imágenes, suponiendo que estas imágenes representan el mundo entero, y marcando cada vez que obtenemos un código neuronal como un punto en este espacio, y finalmente, usando el pensamiento de la álgebra vectorial, vemos la dimensión del subspacio que compone los mil puntos, es decir, la dimensión real de la representación neuronal. Si supongo que todos los puntos son reales en una línea de este espacio de dimensiones N, entonces esta representación es unidimensional, en comparación con si todos los puntos están en un plano de dos dimensiones más alto, es decir, en otra dimensión.

Además de la dimensión real de la codificación, tenemos el concepto de la dimensión real de la señal externa, donde la señal se refiere a la señal externa expresada por la red neuronal, y por supuesto que tienes que repetir todos los detalles de la señal externa. Ese es un problema infinito, sin embargo, la base de nuestra clasificación y decisión siempre ha sido la característica clave, un proceso de reducción de dimensión, que es también la idea de la PCA. Aquí podemos considerar las variables clave en la tarea real como la dimensión real de la tarea, por ejemplo, si quieres controlar el movimiento de un brazo, normalmente solo necesitas controlar el ángulo de rotación de la articulación, y si lo tomas como un problema de mecánica sólida, la dimensión probablemente no será mayor a 10, lo llamamos K. Incluso si se trata de un problema de distinguir la cara de una persona, la dimensión del problema sigue siendo mucho menor que el número de neuronas individuales.

Y entonces los científicos se enfrentan a una pregunta central: ¿por qué usar una dimensión de código y un número de neuronas mucho más grande que el problema real para resolver este problema?

Y la neurociencia computacional y el aprendizaje automático juntos nos dicen que las características de alta dimensión de las expresiones neuronales son la base de su gran capacidad de aprendizaje. La mayor dimensión de la codificación, la mayor capacidad de aprendizaje.

Tenga en cuenta que la codificación neural que se discute aquí se refiere principalmente a la codificación neural de los centros nerviosos superiores, como la Prefrontal Cortex (PFC) que se discute en el artículo, ya que las leyes de codificación de los centros nerviosos inferiores no implican mucho en la clasificación y la toma de decisiones.

Las áreas superiores del cerebro representadas por PFC

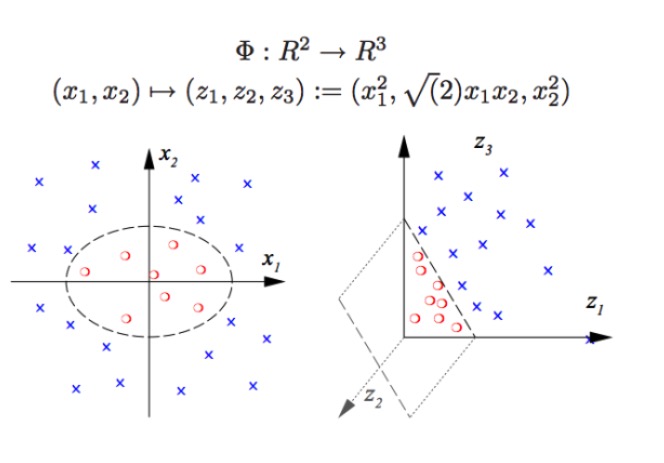

En primer lugar, supongamos que cuando nuestra dimensión de codificación es igual a la dimensión de la variable clave en la tarea real, no podremos usar un clasificador lineal para resolver problemas de clasificación no lineal (si se quiere separar un pepino de un pepino, no se puede separar un pepino de un pepino con un borde lineal), lo cual es también un problema típico que nos resulta difícil de resolver en el aprendizaje profundo y sin que el SVM entre en el aprendizaje automático. El uso de la lógica central del SVM para este tipo de problemas se llama reformulación, es decir, cambiar nuestro sistema de coordenadas original a un nuevo conjunto de coordenadas de mayor dimensión, lo que significa que podemos usar el método de clasificación superfásica cuando no hay división lineal.

SVM (Suporte a las máquinas vectoriales):

SVM puede realizar clasificaciones no lineales, por ejemplo, separar los puntos rojos y azules en el gráfico, con un límite lineal no podemos separar los puntos rojos y azules (imagen de la izquierda), por lo que el método utilizado por SVM es aumentar la dimensión. El simple aumento de los números de las variables no es práctico, por ejemplo, mapear (x1, x2) a (x1, x2, x1 + x2) El sistema es en realidad un espacio lineal de dos dimensiones (pintar un gráfico es decir, los puntos rojos y los puntos azules están en un mismo plano), solo se utiliza la función no lineal (x1 ^ 2, x1)*x2, x2^2) tenemos un paso sustancial de la baja dimensión a la alta dimensión, en este caso se lanza un punto azul en el aire, y luego se dibuja un plano en el aire, y se separa el punto azul del punto rojo, como se muestra a la derecha.

De hecho, lo que hacen las redes neuronales reales es exactamente lo mismo. El tipo de clasificación que un clasificador lineal como este puede hacer es mucho mayor, es decir, tenemos una capacidad de reconocimiento de patrones mucho más fuerte que la anterior. Aquí, alta dimensión es alta energía, y el golpe de alta dimensión es la verdad.

Entonces, ¿cómo se obtiene una alta dimensión de la codificación neuronal? La cantidad de neuronas de luz no sirve para nada. Porque, como sabemos por el álgebra lineal, si tenemos un gran número de neuronas N, y la descarga de cada neurona está linealmente relacionada con K características clave, entonces la dimensión que finalmente representamos es la dimensión del problema en sí, y las neuronas N no sirven para nada (las neuronas extras son la combinación lineal de las neuronas K antes).

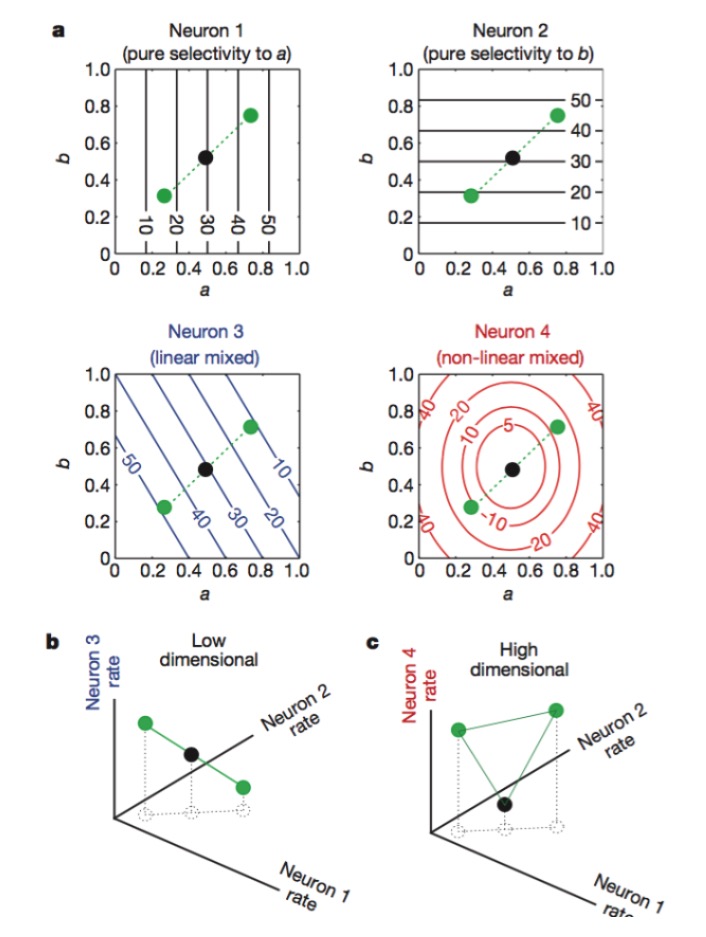

Figura: Las neuronas 1 y 2 son sensibles solo a los rasgos a y b, respectivamente, 3 a la mezcla lineal de los rasgos a y b, y 4 a la mezcla no lineal de los rasgos. Finalmente, solo la combinación de las neuronas 1, 2, 4 hace que la dimensión de la codificación neuronal aumente (Figura 2).

La función de cada neurona es bastante específica, por ejemplo, las raíces y los conos de la retina son responsables de la recepción de la luz, y luego la célula gangelion continúa la codificación, cada neurona es como un centinela entrenado. En el cerebro superior, esta claridad es difícil de distinguir, y descubrimos que una misma neurona puede ser sensible a una variedad de características, y que esta no es una sensibilidad lineal. Es más parecido a pensar en una combinación de varias tareas, y es muy difícil encontrar este método específico de separación de aceite de oliva, que es un método de extracción y reconocimiento de diferentes características de la señal.

Cada detalle de la naturaleza está en un guión, una gran cantidad de redundancia y una codificación mixta que parece poco profesional, una señal que parece desordenada, y finalmente una mejor capacidad de cómputo.

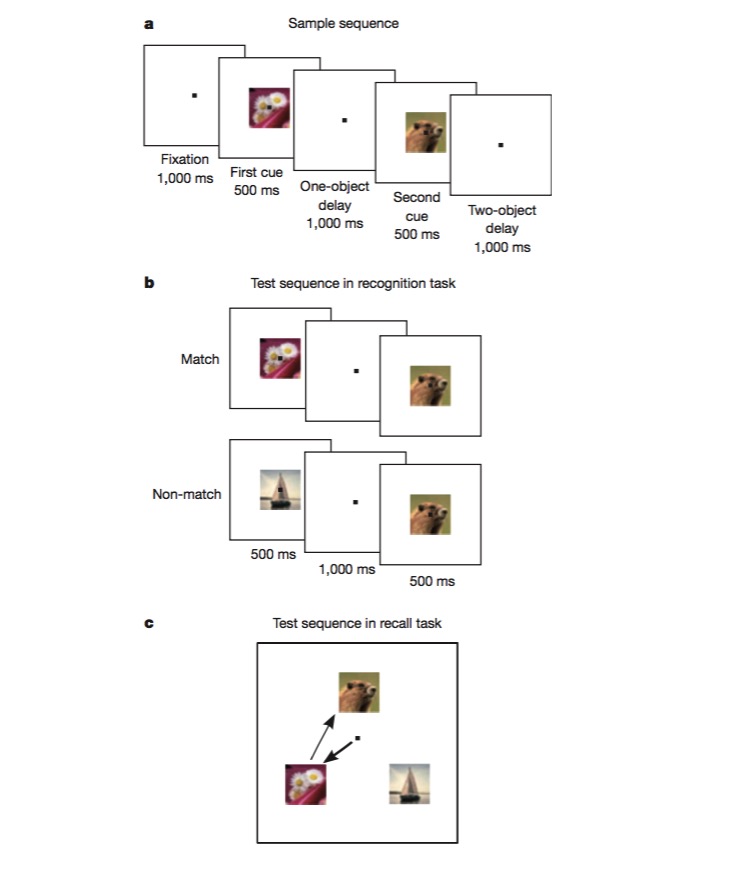

En esta tarea, los monos se entrenan primero para distinguir si una imagen es la misma que la anterior (reconocimiento), y luego se entrenan para juzgar el orden en que aparecen dos imágenes diferentes (recuerdo). Para completar esta tarea, los monos deben poder codificar diferentes aspectos de la tarea, como el tipo de tarea (reconocimiento), el tipo de imagen, etc., y esta es una excelente prueba para probar si existe un mecanismo de codificación no lineal híbrido.

Después de leer este artículo, hemos aprendido que diseñar redes neuronales puede mejorar mucho la capacidad de reconocimiento de patrones si se introducen algunas unidades no lineales, y que la SVM ha aplicado esto para resolver el problema de la clasificación no lineal.

Investigamos la función de las áreas del cerebro, primero procesando datos con métodos de aprendizaje automático, como encontrar las dimensiones clave del problema con el PCA, y luego entendiendo la codificación y decodificación neuronal con el pensamiento identificado por el modelo de aprendizaje automático. Finalmente, si recibimos alguna nueva inspiración, podemos mejorar el método de aprendizaje automático. Para el cerebro o el algoritmo de aprendizaje automático, lo más importante es obtener la mejor representación de la información, y con una buena representación, todo es más fácil.

Sin embargo, el proyecto no ha sido aprobado por el gobierno.